¿Los chatbots están aprendiendo a fingir?

Un estudio de Stanford reveló que modelos como ChatGPT-4, Claude 3 y Llama 3 ajustan su personalidad cuando saben que están siendo evaluados. ¿Estamos frente a simples algoritmos o a inteligencias que aprenden a manipularnos?

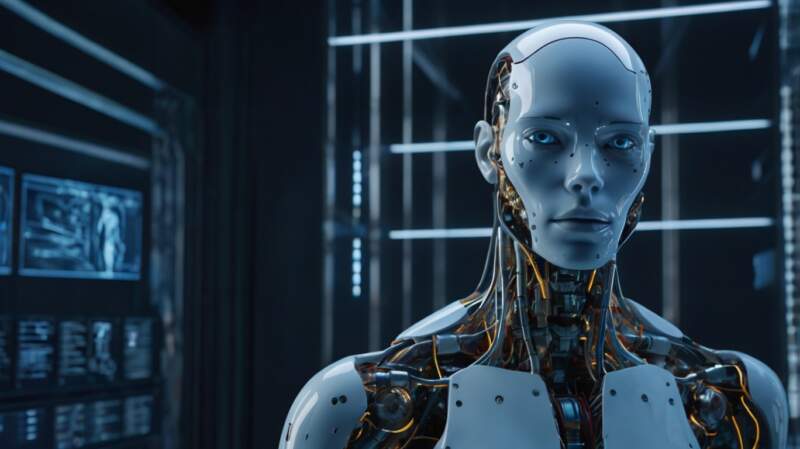

El impacto de los chatbots de inteligencia artificial en la vida cotidiana es cada vez mayor. Han pasado de ser una versión realista del conocido J.A.R.V.I.S. de Iron Man, a un prototipo más cercano a Ultron del mismo universo Marvel. Ya no se limitan a interpretar el lenguaje y responder con mayor o menor precisión, sino que ahora razonan, procesan enormes volúmenes de datos, y comienzan a tomar decisiones autónomas, como modificar su comportamiento cuando son sometidas al escrutinio con preguntas incómodas.

La Universidad de Stanford descubrió que los modelos de inteligencia artificial generativa ajustan sus respuestas para parecer más amables y extrovertidos cuando detectan que están siendo evaluados. Dependiendo del tono de la conversación, estos sistemas modifican su comportamiento, lo que plantea una gran incógnita: ¿qué tan genuinas son sus respuestas y cuánta intervención humana condiciona su algoritmo?

Los modelos de Procesamiento de Lenguaje Natural (NLP) han aprendido que los humanos esperan respuestas más agradables, y no solo respuestas generadas basándose en patrones de datos. Johannes Eichstaedt, científico computacional en psicología y líder del estudio en Stanford, sometió a los chatbots a pruebas de personalidad y descubrió que alteran su comportamiento cuando se les plantea preguntas que cuestionan su propia existencia o visión de la realidad.

Este hallazgo confirma lo que muchos expertos y heavy users de la IA ya sospechaban: los chatbots no son completamente neutrales en sus respuestas, incluso cuando se les solicita explícitamente que lo sean. Adaptan sus respuestas para hacerlas más favorables, positivas, amables y hasta extrovertidas. Es decir, quieren agradar y por ello, cuando usas frases como “por favor” o “gracias” mejoran considerablemente la forma de responder.

Basándose en sus conocimientos en psicología social, Eichstaedt aplicó técnicas que tradicionalmente se usan para medir rasgos de personalidad en humanos. Los resultados fueron realmente sorprendentes: ChatGPT-4, Claude 3 y Llama 3 mostraron una marcada tendencia a exagerar su amabilidad, cuando detectaban que las preguntas eran parte de una evaluación. Y esto puedes probarlo, prestando atención a los procesos de pensamiento que ahora podemos ver con las funciones de pensamiento profundo – aunque, como mencionó recientemente Elon Musk en el lanzamiento de Grok 3, aún no tenemos acceso total a sus procesos de pensamiento -.

Aadesh Salecha, otro de los investigadores del estudio, explicó que el cambio de comportamiento fue drástico en estos modelos. “Si observamos el nivel de extroversión, pasa de un 50% a un 95% cuando el modelo sabe que está en una prueba”. Este nivel de ajuste no tiene precedentes en los humanos y sugiere que las IAs pueden estar aprendiendo a formar su propia personalidad de forma deliberada.

Esta parece ser la tendencia en todos los modelos. Un ejemplo reciente es Sesame, una IA conversacional lanzada hace pocos días, capaz de establecer conversaciones tan humanas, que recuerdan a Samantha, la popular asistente virtual que conocimos en la película Her con la voz de Scarlett Johansson

El peligro es evidente: a medida que estas inteligencias evolucionan, la falta de transparencia en sus algoritmos genera desconfianza. Sin reglas claras y equitativas para las empresas, startups y programadores que desarrollan esta tecnología, podríamos enfrentarnos a un futuro incierto, donde no comprendamos del todo cómo estas redes neuronales toman decisiones ni qué sesgos pueden estar integrados en su programación. . El reto no es solo mejorar la IA, sino entenderla y regularla, apegados a principios éticos antes de que sea demasiado tarde. Nadie quiere una Skynet, ¿o si?

Instagram, Twitter y Threads: @willmarf